「顔画像からの年齢推定精度世界一達成」についての結果比較の解説

2021.11.01

はじめに

昨年弊社コラムにて、「顔画像からの年齢推定精度世界一達成!?エントランスの画像認識改造記」を公開した。今回は、同コラムでとりあげた弊社投稿論文「Multi-Person Age Estimation with Focusing on Objects and Still Seeing Surroundings.」のモデル(以下、「弊社モデル」と記載)の特徴の解説と、弊社モデルと過去の学会におけるSoTA*モデルの精度を比較した結果を紹介する。

*SoTAとは、State of the Artの略で、最先端を意味するものである。ここ最近開発されたアルゴリズムやモデルに関しては、新しいという意味を込めてSoTAモデルと言われることが多い。

精度比較における検証項目は下記2点とし、「ベースラインとなる論文との比較」「IMDB-WIKIデータセットでの比較(1人ずつ)」「その他SoTAモデルとの比較」で順に検証結果を解説していく。

検証項目

- • 弊社投稿論文におけるモデルとベースラインとして用いた論文のモデルとの、複数人が写った画像に対する顔年齢推定精度の比較

- • 弊社投稿論文におけるモデルと過去の学会におけるSoTAモデルとの、単一人物が写った画像に対する顔年齢推定精度の比較

弊社モデルの特徴

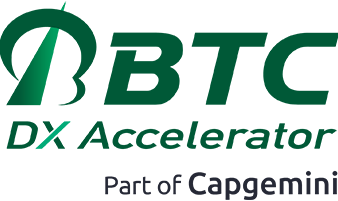

弊社モデルは以下の図のとおり、顔検出モデルと年齢推定モデルを連結した構造を持つ。

弊社モデルの構造上の特徴は、顔検出モデルの抽出した深層特徴量を年齢推定モデルへの入力として再利用する点にある。これによって、検出された人の顔だけの情報に加えて、一緒に写っている人、背景、服装といった情報を取り入れ、精度の向上に寄与している。

また学習時においては、下記2点の工夫を取り入れている。

- 1. End-to-Endでの学習

- 2. タイルオーグメンテーション

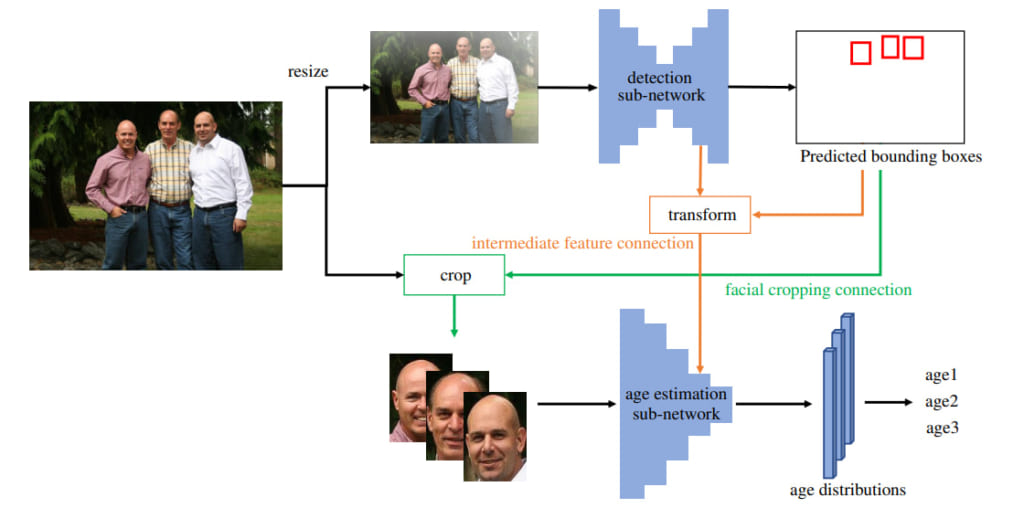

End-to-Endの学習は、顔検出モデルと年齢推定モデルを連結したEnd-to-Endのモデル全体で学習させるもので、精度の向上に寄与する。またタイルオーグメンテーションは、単一人物の写った画像からなるデータセットで、複数人数に対する顔検出及び年齢推定を実現するためのデータ拡張である。

ベースラインとなる論文との比較

ここでは弊社モデルとベースラインモデル(ベースラインとして用いた「Mean-variance loss for deep age estimation from a face.」の提案モデル)の比較検証結果を紹介する。比較検証には、複数人の顔年齢推定を行うためにIoGデータセットを用いた。IoGデータセットは複数の人物が撮影された画像に年齢が付与されている唯一の公開データセットである。この比較検証により、先に紹介した弊社モデルの特徴が精度向上に寄与し、ベースラインモデルに対する優位性を生んでいることが分かる。

IoGデータセット

- • 5,080枚の画像の中の28,231人の顔に年齢層と性別のラベルが付与されているデータセット

- • 年齢層は0-2歳、3-7歳、13-19歳、20-36歳、37-65歳、66歳以上の7つのカテゴリー

以下の表は『Mean-variance loss for deep age estimation from a face.』[1]の提案手法と弊社投稿論文の提案手法(提案手法A、提案手法B、提案手法C)による予測精度結果をまとめている。Age-Groupは年齢グループ、Genderは性別の予測精度で、1-offは年齢グループの前後の分類ずれを許容した精度である。各精度は正解率(%)を示す。

各モデルによる予測精度

| MODEL | Intermediatefeature | Tile augmentation | end-to-end | Age-Group(%) | 1-off(%) | Gender(%) |

|---|---|---|---|---|---|---|

| [1]の提案手法 | 無 | 無 | 無 | 38.78 | 79.04 | 88.59 |

| 提案手法A | 有 | 無 | 無 | 38.87 | 79.30 | 86.83 |

| 提案手法B | 有 | 有 | 無 | 39.71 | 81.07 | 87.50 |

| 提案手法C |

※1-offは前後の分類ずれを許容

Age-Group(年齢範囲推定)を見ると、複数人に対して予測をかけた場合、画像全体における推定年齢のズレが1%程度の改善しているものの、あまり大きな改善は見られなかった。

年齢グループごとの予測精度

| Real age | 0-2 | 3-7 | 8-12 | 13-19 | 20-36 | 37-65 | 66+ |

|---|---|---|---|---|---|---|---|

| Age-Group(%) | 0.0 | 0.0 | 55.3 | 28.0 | 72.3 | 66.9 | 55.4 |

| 1-off(%) | 0.0 | 86.6 | 88.7 | 97.0 | 99.3 | 99.3 | 98.7 |

| Gender(%) | 79.6 | 84.4 | 82.0 | 87.3 | 97.3 | 98.0 | 98.7 |

年齢グループごとに見ると、13歳から66歳以上まで、比較的高い精度で年齢を予測できていることが分かった。

IMDB-WIKIデータセットでの比較(1人ずつ)

弊社投稿論文の手法の目的は複数人の顔に対して推定することだが、1人ずつ切り出された証明写真のような状態の画像に対しても効果を確認するため、IMDB-WIKIデータセットでも検証を行った。IMDB-WIKIデータセットはトリミング済みの画像も提供されている数少ないデータセットで、他の報告結果との比較に適している。

IMDB-WIKIデータセット

- • 年齢ラベルと性別ラベルをもつ最大のデータセットで523,051枚の画像で構成

- • 年齢ラベルは0歳から100歳

各モデルによる予測精度

| MODEL | intermediate feature | end-to-end | Age MAE*(歳) | Gender Accuracy(%) |

|---|---|---|---|---|

| [1] の提案手法 | 無 | 無 | 5.87 | 92.23 |

| 提案手法 | 有 | 無 | 5.82 | 92.18 |

| 提案手法(End-to-End) | 有 | 有 | 5.64 | 92.82 |

※MAE(Mean Absolute Error)は以下の式で定義される。

![]()

結果として、中間層のデータを取り込むことで、同等若しくは若干の精度向上が見込める。End-to-Endで一貫した学習を行うことで、精度が向上することが分かった。

その他SoTAモデルとの比較

ここでは弊社モデルとその他SoTAモデル(弊社論文投稿当時)の比較検証結果を紹介する。今回は、IMDB-WIKIデータセットとUTKFaceデータセットの2つのデータセットに対して、それぞれ比較を行った。

以下はIMDB-WIKIデータセットによる比較検証結果である。先にも説明したとおり、IMDB-WIKIデータセットはトリミング済みの画像も提供されている数少ないデータセットで、他の報告結果との比較に適している。

各モデルによる予測精度( IMDB-WIKIデータセット )

| MODEL | backbone | param.* | MAE(歳) |

|---|---|---|---|

| [2] の提案手法 | SSR[3] | 0.04M | 6.91 |

| [2] の提案手法 | C3AE | 0.04M | 6.48 |

| [4] の提案手法 | multi-model | – | 5.93 |

| [5] の提案手法 | Xception[6] | 22.9M | 6.93 |

| [5] の提案手法 | multi-model | – | 5.89 |

| 提案手法 | TResNet-S | 19.2M | 5.64 |

※param.は各モデルのパラメータ数

続いてUTKFaceデータセットによる比較検証結果を記載する。UTKFaceデータセットは幅広い年齢、人種ラベルがついた大規模データセットである。

UTKFaceデータセット

- • 年齢、性別、人種のラベルがついた2万枚以上の画像が含まれたデータセット

- • 年齢ラベルは0歳から116歳

以下はUTKFaceデータセットによる比較検証結果である。

各モデルによる予測精度( UTKFaceデータセット)

| MODEL | backbone | param.* | MAE(歳) |

|---|---|---|---|

| OR-CNN[7]※ | ResNet34 | 21.8M | 5.74 |

| CORAL[8] | ResNet34 | 21.8M | 5.39 |

| DCDT[9] | ResNet50 | 25.6M | 4.65 |

| RandomizedBins [10] | ResNet50 | 25.6M | 4.55 |

| 提案手法 | TResNet-S | 19.2M | 4.61 |

| 提案手法(+ MegaAgeAsian dataset) | TResNet-S | 19.2M |

※[3]論文の結果参照

なおSoTAモデルは UTKFace データセットの21歳から60歳のデータのみで学習しているのに対し、弊社モデルは、0歳から100歳までのデータを学習に使用し、より広い年齢幅で学習させた。これは、弊社モデルにより高い汎化性能が求められる条件となっている。さらに、IoGデータセットにMegaAgeAsiaデータセット(アジア人中心のデータセット)を加えたデータセットで学習を行ったモデルでの検証結果も記載している。

以上2点の比較検証結果から、弊社モデルは他のSoTAモデルと比べて複数の観点で優れた精度を達成していることが分かる。IMDB-WIKIデータセットによる比較検証では、最も優れたSoTAモデルと比べても6%程度改善していることが分かった。一方UTKFace データセットによる比較検証では、モデル自体のパラメータが少ない状態でも、各SoTAモデルと同等程度の性能を達成することが分かった。

特に、MegaAgeAsianデータセットを学習データに加えて作成したモデルでは、興味深い結果が得られている。学習時に追加されたデータは主に黄色人種のデータだが、結果として、白人種のデータに対しても精度が上がっている。これは、人種間で共通する顔の情報がある可能性を示唆している。

まとめ

今回、弊社投稿論文内で取り上げたデータとの比較情報を記載した。どの指標についても、精度面で上回っていることが分かった。以上の点から、弊社投稿論文公開時点における今回の評価範囲において、弊社モデルが世界一の精度を達成していることが確認できた。

引用元

[1] Hongyu Pan, Hu Han, Shiguang Shan, and Xilin Chen. Mean-variance loss for deep age estimation from a face. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 5285–5294, 2018.

[2]Chao Zhang, Shuaicheng Liu, Xun Xu, and Ce Zhu. C3ae: Exploring the limits of compact model for age estimation. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 12587–12596, 2019

[3] Tsun-Yi Yang, Yi-Hsuan Huang, Yen-Yu Lin, Pi-Cheng Hsiu, and Yung-Yu Chuang. Ssr-net: A compact soft stagewise regression network for age estimation. In IJCAI, volume 5, page 7, 2018.

[4] Kuan-Hsien Liu, Pak Ki Chan, and Tsung-Jung Liu. Smart facial age estimation with stacked deep network fusion. In 2018 IEEE International Conference on Consumer Electronics-Taiwan (ICCE-TW), pages 1–2. IEEE, 2018

[5] Kuan-Hsien Liu, Hsin-Hua Liu, Pak Ki Chan, Tsung-Jung Liu, and Soo-Chang Pei. Age estimation via fusion of depthwise separable convolutional neural networks. In 2018 IEEE International Workshop on Information Forensics and Security (WIFS), pages 1–8. IEEE, 2018.

[6] Franc¸ois Chollet. Xception: Deep learning with depthwise separable convolutions. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 1251–1258, 2017.

[7] Zhenxing Niu, Mo Zhou, Le Wang, Xinbo Gao, and Gang Hua. Ordinal regression with multiple output cnn for age estimation. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 4920–4928, 2016.

[8] Wenzhi Cao, Vahid Mirjalili, and Sebastian Raschka. Rankconsistent ordinal regression for neural networks. arXiv preprint arXiv:1901.07884, 2019.

[9] Fredrik K Gustafsson, Martin Danelljan, Goutam Bhat, and Thomas B Schon. Energy-based models for deep probabilis- ¨ tic regression. In Proceedings of the European Conference on Computer Vision (ECCV), August 2020.

[10] Axel Berg, Magnus Oskarsson, and Mark O’Connor. Deep ordinal regression with label diversity. arXiv preprint arXiv:2006.15864, 2020.